Рассмотрим несколько лучших SSD-накопителей на сегодняшний день.

1. Samsung 990 PRO - лучший твердотельный накопитель M.2

Емкость: 1TB, 2TB, 4TB | Интерфейс: PCIe Gen 4.0 x4 | Скорость последовательного чтения: 7,450 MB/s | Скорость последовательной записи: 6,900 MB/s | NAND: TLC | Гарантия: 5 лет.

Плюсы:

Очень быстрая производительность;

Встроенный радиатор для плавной работы.

Встроенный радиатор для плавной работы.

Минусы:

Высокая стоимость.

Samsung 990 Pro — один из лучших твердотельных накопителей, поэтому неудивительно, что он возглавляет этот список. Во многом благодаря быстрому контроллеру 990 Pro является одним из самых быстрых накопителей PCIe 4.0. Мы говорим о скорости последовательного чтения до 7450 МБ/с и случайного чтения до 1,2 миллиона операций ввода-вывода в секунду — это означает, что независимо от того, загружаете ли вы компьютер или пытаетесь загрузить матч, это происходит быстрее, чем у других накопителей. Однако это флагманский твердотельный накопитель Samsung, и это значит, что он немного дороговат.

2. WD Black SN850X - лучший твердотельный накопитель M.2 для игр

Емкость: 500GB, 1TB, 2TB | Интерфейс: PCIe Gen 4.0 x4 | Скорость последовательного чтения: 7,300 MB/s | Скорость последовательной записи: 6,400 MB/s | NAND: TLC | Гарантия: 5 лет.

Плюсы:

Высокая производительность;

Поставляется со своим собственным пакетом программного обеспечения.

Поставляется со своим собственным пакетом программного обеспечения.

Минусы:

Варианты с ограниченной емкостью.

Линейка накопителей Western Digital Black используется для компьютерных игр с начала 2000-х годов, поэтому, если вам надоело ждать загрузки игр, твердотельный накопитель WD_Black SN850X должен быть в верхней части вашего списка. Благодаря высокой скорости случайного чтения/записи этот накопитель особенно хорош при загрузке игр. SN850X также поставляется с пакетом программного обеспечения Western Digital, который позволяет отслеживать состояние накопителя и с течением времени оптимизировать его производительность. Добавьте к этому надежную гарантию, и вы можете быть уверены, что этот накопитель прослужит долгие годы. Кроме того, он поставляется в варианте с прикрепленным радиатором, который идеально подходит для PS5.

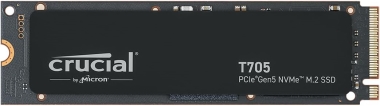

3. Crucial T705 - лучший твердотельный накопитель PCIe 5.0 M.2

Емкость: 1TB, 2TB, 4TB | Интерфейс: PCIe Gen 5.0 x 4 | Скорость последовательного чтения: 13,600 MB/s | Скорость последовательной записи: 10,200 MB/s | NAND: TLC | Гарантия: 5 лет.

Плюсы:

Конкурентная цена;

Разнообразие емкости.

Разнообразие емкости.

Минусы:

Использует PCIe Gen 3, поэтому он немного медленнее.

Crucial T705 - это накопитель PCIe 5.0 со скоростью чтения/записи до 13 600/10 200 МБ/с. Стоимость этого накопителя начинается от 175 долларов, и он невероятно быстро масштабируется, если вы попытаетесь получить больше места для хранения. Однако, если ваша рабочая нагрузка включает такие приложения, как Adobe Premiere и Blender, эта мощность со временем окупится. Но если вы просто хотите установить SSD в свой игровой компьютер, возможно, оно того не стоит.

4. Kingston NV2 - лучший бюджетный твердотельный накопитель M.2

Емкость: 250GB, 500GB, 1TB, 2TB | Интерфейс: PCIe Gen 4.0 x4 | Скорость последовательного чтения: 3,500 MB/s | Скорость последовательной записи: 2,800 MB/s | NAND: QLC | Гарантия: 3 года.

Плюсы:

Отличная цена;

Фантастическая производительность для базовых задач.

Фантастическая производительность для базовых задач.

Минусы:

Короткая гарантия.

Гораздо более удобным для кошелька твердотельным накопителем M.2 является Kingston NV2. Вы теряете часть теоретической скорости других дисков, но для большинства людей разница в лучшем случае будет незначительной. Что действительно снижает цену, так это память QLC NAND, которая немного менее долговечна, чем TLC NAND. Тем не менее, этот диск прослужит долгие годы без проблем.

Этот твердотельный накопитель M.2 значительно превосходит традиционные жесткие диски (HDD) благодаря высокой скорости чтения/записи до 3500/2400 МБ/с. Это делает его идеальным для тех, кто ищет бюджетный диск для своего ПК. Этот накопитель теоретически также достаточно быстр для PS5, но для его установки вам придется купить радиатор.

5. Corsair MP600 PRO LPX - лучший твердотельный накопитель M.2 для компактных сборок

Емкость: 500GB, 1TB, 2TB, 4TB, 8TB | Интерфейс: PCIe Gen 4.0 x4 | Скорость последовательного чтения: 7,100 MB/s | Скорость последовательной записи: 6,800 MB/s | NAND: TLC | Гарантия: 5 лет.

Плюсы:

Компактная конструкция;

Фантастика для PS5.

Фантастика для PS5.

Минусы:

Необязательный радиатор.

Corsair все еще новичок в сфере твердотельных накопителей, но Corsair MP600 PRO LPX — это отличный выбор для тех, кто увлекается играми или создает контент, так как он обеспечивает невероятную скорость чтения/записи до 7100/6800 МБ/с. Однако есть небольшой недостаток. Поскольку этот диск продается только с прикрепленным радиатором, его сложно использовать с некоторыми из лучших материнских плат, в которых используются собственные радиаторы SSD. Однако это не проблема, если вы пытаетесь добавить его в свою PS5. Кроме того, даже со встроенным радиатором Corsair MP600 Pro LPX имеет низкопрофильный дизайн, что делает его идеальным выбором для компактных сборок.

Как выбрать лучший твердотельный накопитель M.2?

Твердотельные накопители M.2 бывают разных размеров, поэтому первым делом нужно взглянуть на материнскую плату, чтобы определить, какой тип накопителей M.2 она поддерживает. По большей части вы можете безопасно использовать диск M.2 2280, но некоторые компактные материнские платы ограничивают вас диском меньшего размера, например M.2 2230.

Как правило, чем новее SSD, тем быстрее он будет. В настоящее время на рынке появляются диски PCIe 5.0, которые теоретически быстрее, чем предыдущие диски PCIe 4. Однако эта дополнительная скорость будет разблокирована только в том случае, если вы соедините ее с новым процессором — новее, чем 12-е поколение для Intel или 7-е поколение для AMD. Не волнуйтесь, если вы случайно подберете диск PCIe 5.0 со старым процессором: если на материнской плате вашего компьютера есть слот M.2, он будет работать, просто не так быстро, как возможно.

Если вы специально ищете твердотельный накопитель для PS5, вам следует убедиться, что он оснащен радиатором. Вы также можете купить радиатор SSD на вторичном рынке, просто убедитесь, что он подходит к слоту SSD PS5.

Вам также следует убедиться, что приобретаемый вами диск достаточно быстр и совместим. Технически у Sony есть список совместимых накопителей, но он обычно немного отстает от выхода новых накопителей. Как правило, нужно подбирать твердотельный накопитель M.2 с интерфейсом PCIe 4.0 или новее, который может обеспечить скорость последовательного чтения до 5500 МБ/с.

Наконец, есть цена. Раньше твердотельные накопители M.2 были чрезвычайно дорогими, но теперь, когда они стали своего рода форм-фактором по умолчанию для твердотельных накопителей, цены значительно упали. Вы можете найти диски M.2 емкостью 1 ТБ примерно за 100 долларов, а если вам просто нужен диск емкостью 120 ГБ для установки ОС, вы можете обойтись всего 20 долларами.

Более подробную информацию о твердотельных накопителях можно получить в нашем интернет-магазине Raidshop.ru